多模态深度学习

多模态深度学习网络学习

开始日期:2026-01-12

当前目标阶段:入门->科研->多模态大模型->项目

学习材料主线:文档->论文->项目

备注:记录要尽量“可复现”,包含版本、超参、数据集、链接与结论

1. 多模态、跨模态、多任务

多模态是多种模态进行处理分析

多任务是多个模型同时执行多个任务

跨模态是指一个模态中学习到的知识应用在另一个模态的数据上

- 跨模态是一种多模态深度学习方法

- 多模态深度学习模型方法:

- 翻译:模式之间的映射关系

- 对齐:模态子元素之间的直接关系

- 融合:结合多个模态数据进行预测

- 协同学习:一种模型中学习到的帮助不同模态上训练的计算模型

- 表征:利用多模态之间的互补性来总结多模态数据

- 多模态深度学习的五个挑战:模态表示、模态传译、模态对齐、模态融合

1.1 语句模态的表示方法(word-embedding)

单词模态的独热表示(one-hot)

低维空间表示:独热表示的线性变换

词袋模型:只考虑每个词的出现频率,将频率作为特征地图,不考虑文字的顺序和语法结果

- n-gram:可以捕捉语义结构和上下文信息,维度会 迅速增长。将短语或者一个句子视为一个词袋再统计次数,n表示构成词袋的单词个数,对于每个句子按照n个单词对句子进行拆分。bigarm表示n=2,trigram表示n=3。

- TF-IDF:评估词语对文档中的重要性。如果某个词语在一篇文档中频繁出现,但在其他文档中很少出现,则认为这个词语具有很好的类别区分能力,对文档的区分度高,因此应该给予更高的权重。

TF(词频)表示词语在文档中出现的频率,等于某个词在文档中出现的次数除以总词汇数字。

IDF(逆文档频率)如果一个某个词在很多文档中出现,IDF的值会减小,从而减低值的权重

最终得到的值是TF与IDF相乘

文档词项矩阵(Document-Term Matrix):统计每个词语在每个文档中出现的次数。(既有词频又考虑了不同文档,但是依赖文档结构)

替代方法:词词矩阵(Term-Term Matrix):统计词语文本中上下文的频率来理解含义。(有点像qkv?只是最后落到的点不同?)

单词序列模态的语义空间表示(解决上述方法在维度过高的问题):

- 加权平均语义表示向量

- 句子解析树构成矩阵

- 深度学习方法:

- Worf2Vec:训练神经网络分类器预测词的共现(使用上下文窗口来建立每个词的上下文内容,窗口大小确定了上下文范围)

- 输入输出使用的都是独热编码,输入词汇输出每个词汇上下文的概率,使用的是softmax损失函数。维度在100-1000维之间,进行分析时可以使用PCA或者t-SNE这样的降维。

- 缺点很明显:虽然考虑了上下文但是只考虑了出现的概率没考虑具体的语境和句子的实际含义和具体的语序(输入仅仅为单个的词语)

- Glove:将使用的上下文窗口更换为全局的词共现矩阵(整个数据集)

- 词共现矩阵:就是上文说到的词词矩阵但是把视野放到了整个数据集当中,同样没考虑词序的问题(主语谓语宾语)

- Worf2Vec:训练神经网络分类器预测词的共现(使用上下文窗口来建立每个词的上下文内容,窗口大小确定了上下文范围)

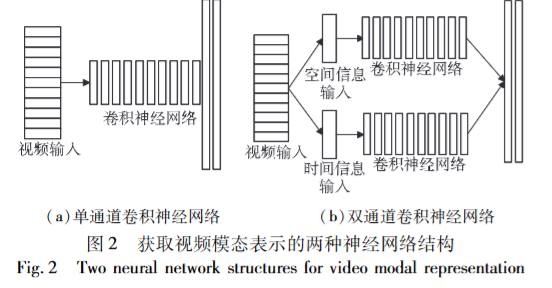

1.2 视频模态的表示方法

- 不想记录了,截张图吧

2. 学习路线与里程碑(Roadmap)

2.1 路线图(按阶段)

阶段 A:基础概念与经典结构(预计:__ 周)

- 多模态表示学习基础:对齐/融合/协同

- Transformer 基础与跨模态注意力

- 对比学习/自监督在多模态中的范式

阶段 B:论文复现与实验(预计:__ 周)

- 选择基线模型:__

- 复现论文 1:__(链接)

- 复现论文 2:__(链接)

阶段 C:项目化/论文写作(预计:__ 周)

- 数据集清洗与规范化流程

- 设计改进点与消融实验

- 整理论文结构/实验图表

2.2 里程碑(Milestones)

| 里程碑 | 目标 | 截止 | 状态 | 备注 |

|---|---|---|---|---|

| M1 | 跑通一个多模态 baseline | YYYY-MM-DD | ⬜/🟨/✅ | |

| M2 | 复现 1 篇论文主结果 | YYYY-MM-DD | ⬜/🟨/✅ | |

| M3 | 完成消融实验与对比 | YYYY-MM-DD | ⬜/🟨/✅ |

3. 周记录(Weekly Log)

建议:每周一写计划,每天写简短日志,每周末写复盘

第 __ 周(YYYY-MM-DD ~ YYYY-MM-DD)

3.1 本周计划(Plan)

- 主题/模块:

- 预计完成:

- 预期困难与应对:

- 困难:

- 应对策略:

3.2 每日记录(Daily)

YYYY-MM-DD(Day __)

- 今日学习内容:

- 关键概念/公式(尽量用你自己的话):

- 阅读材料(论文/课程/博客):

- 标题:

- 链接:

- 读到哪里:

- 代码/实验:

- 仓库/分支:

- 环境:Python __ / PyTorch __ / CUDA __

- 运行命令:

- 结果(指标/现象):

- 问题与卡点:

- 明日计划(1-3 条):

(按天复制以上块即可)

3.3 本周复盘(Review)

- ✅ 本周完成了什么(可量化):

- ❌ 没完成的原因:

- 📌 最重要的收获(3 条以内):

- 🧪 需要补做的实验/验证:

- 🔁 下周计划调整:

4. 论文阅读卡片(Paper Cards)

一篇论文建议用 10~20 分钟先写“粗读卡片”,再做精读补全

论文:标题

- 作者/年份:

- 领域与任务:例如「V-L 对齐 / 多模态分类 / 生成 / 检索」

- 链接:arXiv / PDF / repo

- 一句话贡献(你自己的话):

- 方法核心(结构图/关键模块):

- 损失函数与训练策略:

- 数据集与指标:

- 实验亮点:

- 局限性/可能失败的场景:

- 我能复现什么:

- 我能改进什么(与自己课题结合):

- 复现记录(commit / log 链接):

5. 模型与实验记录(Experiments)

5.1 实验设置(固定信息)

- 任务定义:

- 数据集:名称 / 版本 / 划分方式 / 预处理

- 模态:例如 图像+文本 / EEG+EMG / 音频+视频

- 评价指标:

- 硬件:GPU / 显存 / 训练时长

- 代码仓库:

- 随机种子:

5.2 实验条目(每次实验复制一份)

实验编号:EXP-YYYYMMDD-__

- 目的(要验证什么假设):

- 变量(只改哪些东西):

- 配置:

- backbone:

- fusion:

- loss:

- lr / batch / epoch:

- 结果(表格建议):

| 指标 | 值 |

|---|---|

| Acc/F1 | |

| mAP | |

| Loss |

- 结论(是否支持假设):

- 下一步动作:

6. 知识点索引(Concept Index)

把学过的概念按主题维护,方便回忆与查找

6.1 表示/对齐/融合

- 对齐(Alignment):

- 融合(Fusion):早/中/晚融合

- 协同学习(Co-learning):

6.2 常见多模态结构

- Cross-Attention:

- Co-Attention:

- Gated Fusion / FiLM:

- Multimodal Transformer:

6.3 多模态学习范式

- 对比学习(CLIP-style):

- 蒸馏(Distillation):

- 自监督(Masked Modeling):

7. 待办与问题池(Backlog)

7.1 待办(TODO)

7.2 问题池(Questions)

遇到问题先记下来,集中检索/请教/实验验证

1.

2.

3.

8. 资源库(Resources)

8.1 课程/书

- 名称 - 链接 - 学到第几节

8.2 论文清单(Reading List)

| 状态 | 论文 | 主题 | 优先级 | 备注 |

|---|---|---|---|---|

| ⬜/🟨/✅ | 1-5 |

8.3 代码与工具

- repo:

- 常用脚本:

- 评测工具:

9. 输出物(Outputs)

强烈建议每周至少一个可展示产出

- 笔记/博客:

- 复现报告:

- 实验图表:

- 周报/组会 PPT:

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Blog for AI!